7 个版本 (重大更改)

| 0.7.0 | 2024 年 7 月 21 日 |

|---|---|

| 0.6.0 | 2024 年 4 月 30 日 |

| 0.5.0 | 2024 年 4 月 14 日 |

| 0.4.0 | 2024 年 4 月 13 日 |

| 0.1.0 | 2024 年 3 月 28 日 |

#460 在 命令行工具 中

每月下载量 165

740KB

922 行

cai - 最快速的 LLM 提示 CLI 工具

功能

- 使用 Rust 🦀 构建,以实现极致的性能和速度!🏎️

- 支持 Groq、OpenAI、Anthropic 和本地 LLM 的模型。📚

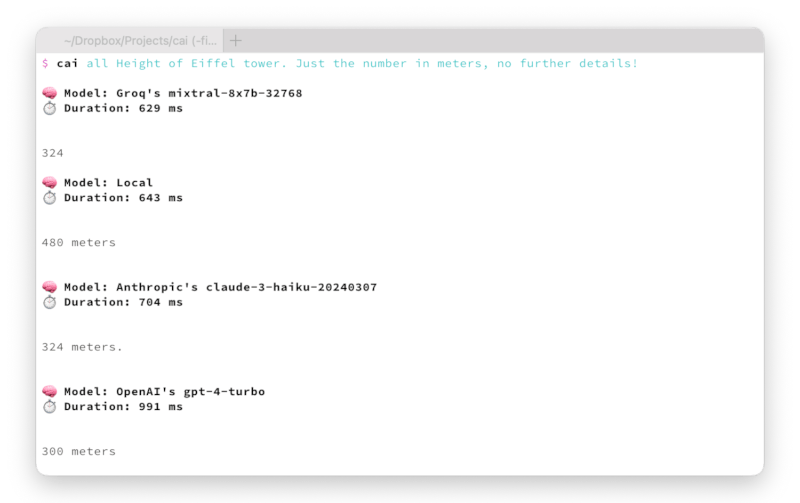

- 一次提示多个模型。🤼

- 代码片段语法高亮,便于阅读。🌈

演示

安装

cargo install cai

用法

在开始使用 Cai 之前,必须设置 API 密钥。只需在终端中执行 cai 并按照说明操作即可。

Cai 支持以下 API

- Groq - 创建新的 API 密钥。

- OpenAI - 创建新的 API 密钥。

- Anthropic - 创建新的 API 密钥。

- Llamafile - 运行在 https://:8080 的本地 Llamafile 服务器。

- Ollama - 运行在 https://:11434 的本地 Ollama 服务器。

之后,您可以使用 cai 在终端中直接运行提示

cai List 10 fast CLI tools

或特定的模型,例如 Anthropic 的 Claude Opus

cai op List 10 fast CLI tools

完整帮助输出

$ cai help

Cai 0.6.0

The fastest CLI tool for prompting LLMs

Usage: cai [OPTIONS] [PROMPT]... [COMMAND]

Commands:

groq Groq [aliases: gr]

ll - Llama 3 shortcut (🏆 Default)

mi - Mixtral shortcut

openai OpenAI [aliases: op]

gp - GPT-4o shortcut

gm - GPT-4o mini shortcut

anthropic Anthropic [aliases: an]

cl - Claude Opus

so - Claude Sonnet

ha - Claude Haiku

llamafile Llamafile server hosted at https://:8080 [aliases: lf]

ollama Ollama server hosted at https://:11434 [aliases: ol]

all Simultaneously send prompt to each provider's default model:

- Groq Llama3

- Antropic Claude Sonnet 3.5

- OpenAI GPT-4o mini

- Ollama Llama3

- Llamafile

help Print this message or the help of the given subcommand(s)

Arguments:

[PROMPT]... The prompt to send to the AI model

Options:

-r, --raw Print raw response without any metadata

-j, --json Prompt LLM in JSON output mode

-h, --help Print help

Examples:

# Send a prompt to the default model

cai Which year did the Titanic sink

# Send a prompt to each provider's default model

cai all Which year did the Titanic sink

# Send a prompt to Anthropic's Claude Opus

cai anthropic claude-opus Which year did the Titanic sink

cai an claude-opus Which year did the Titanic sink

cai cl Which year did the Titanic sink

cai anthropic claude-3-opus-20240229 Which year did the Titanic sink

# Send a prompt to locally running Ollama server

cai ollama llama3 Which year did the Titanic sink

cai ol ll Which year did the Titanic sink

# Add data via stdin

cat main.rs | cai Explain this code

相关

依赖项

~23–39MB

~652K SLoC